la microelettronica sta per cambiare – Lorenzo Baldi

Apple ha recentemente annunciato che utilizzerà processori di propria progettazione nei computer Macintosh, interrompendo la partnership con Intel, durata più di 15 anni.

Questi processori apparterranno alla stessa famiglia che equipaggia già gli iPhone e gli iPad. È la quarta volta che la casa di Cupertino adotta un nuovo tipo di processore, dopo i Motorola 68000, i Power PC e, appunto, Intel. Lo stesso non si può dire del mondo PC che, dal primo IBM del 1981 ad oggi, si è affidato ad una stessa famiglia di CPU.

iPhone e gli iPad. È la quarta volta che la casa di Cupertino adotta un nuovo tipo di processore, dopo i Motorola 68000, i Power PC e, appunto, Intel. Lo stesso non si può dire del mondo PC che, dal primo IBM del 1981 ad oggi, si è affidato ad una stessa famiglia di CPU.

Questo la dice lunga sulla capacità e volontà di innovazione di Apple, perché sostituire il microprocessore in un computer non è un’operazione banale. Ogni famiglia di processori, infatti, si caratterizza per un set di istruzioni, più o meno semplici, che i circuiti sono in grado di eseguire; mentre le applicazioni sono programmate utilizzando dei linguaggi più simili al linguaggio umano.

Ciò significa che tutti gli sviluppatori di software sono chiamati a ricompilare i programmi nella lingua parlata dal nuovo microprocessore, attraverso strumenti automatizzati forniti dalla casa madre, ma anche con un impegnativo lavoro di ottimizzazione. C’è anche la necessità di permettere agli utenti di utilizzare le loro applicazioni preferite, durante il periodo di transizione. E, infine, bisogna garantire ai clienti che possiedono macchine di vecchia generazione un supporto abbastanza prolungato da non renderle obsolete troppo rapidamente.

Ma perché Apple si sottopone a questo enorme sforzo tecnico e organizzativo?

La prima ragione riguarda il miglioramento della nostra esperienza digitale. Questo cambiamento promuove, infatti, una rapida convergenza di tutti gli strumenti informatici, siano essi smartphone, tablet, portatili, fissi o workstation, attraverso un’unica architettura tecnica ed uno sviluppo comune del software, declinato solamente in base alle dimensioni del display e al tipo di interazione dell’utente, che sia con lo schermo tattile o con il mouse.

La prima ragione riguarda il miglioramento della nostra esperienza digitale. Questo cambiamento promuove, infatti, una rapida convergenza di tutti gli strumenti informatici, siano essi smartphone, tablet, portatili, fissi o workstation, attraverso un’unica architettura tecnica ed uno sviluppo comune del software, declinato solamente in base alle dimensioni del display e al tipo di interazione dell’utente, che sia con lo schermo tattile o con il mouse.

Saremo sempre più liberi di usare quel che più conviene al nostro stile di vita, dovremo imparare l’impiego di un solo programma per tutte le piattaforme hardware, potremo concentrarci di più sulle attività creative.

Ma c’è anche una ragione più strategica. Probabilmente, avete sentito parlare della legge di Moore. Nel 1965, Gordon Moore, allora direttore Ricerca & Sviluppo della Fairchild e, qualche anno dopo, co-fondatore di Intel, pubblicò un articolo sulla rivista Electronics, nel quale si sosteneva che il numero di transistor contenuti in un microprocessore sarebbe più o meno raddoppiato nel giro di 18-24 mesi.Questa profezia si è autoavverata, diventando per lungo tempo il criterio stesso utilizzato dall’industria elettronica per programmare gli obiettivi di ricerca e sviluppo.

Cinquant’anni dopo l’articolo di Gordon Moore, l’istituto di studi economici IHS ha pubblicato un rapporto intitolato Celebrating the 50th Anniversary of Moore’s Law nel quale si evidenziano gli effetti sociali, ambientali ed economici della crescita tecnologica esponenziale avvenuta durante mezzo secolo di crescente informatizzazione delle aziende e della vita personale. Vale la pena citare qualche dato.

Dal 1995 al 2015, la crescita tecnologica correlata alla legge di Moore ha contribuito per l’ 1% ogni anno alla crescita del PIL mondiale, per una cifra assoluta di 3 trilioni di dollari (miliardi di miliardi); gli effetti indiretti sono misurabili in 11 trilioni.

Il mondo si è interconnesso: nel 2015 erano attivi 6,8 miliardi di contratti di telecomunicazione mobili, 3,6 miliardi di smartphone, 600 milioni di tablet, 925 milioni di contratti pay-tv, 2 miliardi di utenti di social media, 288 milioni di domini internet.

Il fatturato della pubblicità on-line era di 165 miliardi e quello per il video digitale ed i videogiochi di 86. Nel 2013, il numero di lettere gestite dalle Poste statunitensi si è ridotto di 34,6 miliardi rispetto al 1998. Per quanto riguarda la ridislocazione della produzione manifatturiera, il più che raddoppio del trasporto marittimo delle merci tra il 2000 e il 2020 è un indicatore inequivocabile.

Il rapporto evidenzia anche l’impatto dello sviluppo dei semiconduttori sulla sostenibilità: il costo per sequenziare il genoma umano, tra il 2000 e il 2015 si è ridotto di 500 volte, aprendo la strada allo sviluppo di terapie individualizzate. La crescita esponenziale dell’installazione di pannelli solari, la riduzione delle perdite di rete nella distribuzione dell’energia elettrica, lo sviluppo della motorizzazione elettrica e dei sistemi di sicurezza nei trasporti su gomma sono tutti resi possibili da questa tecnologia.

In sintesi, la crescita della velocità di calcolo dei microprocessori è stato uno dei fondamentali fattori di crescita dell’economia ed è stato alla base dei processi di globalizzazione. Ma, ad un certo punto, hanno cominciato a mostrarsi delle difficoltà, un possibile rallentamento che rischia di avere grandi conseguenze anche sul piano macroeconomico.

Forse avrete sentito parlare di un processore a 3,5, oppure a 4 Ghz. Fino al 2004 i miglioramenti tecnologici nel processo produttivo dei microprocessori sono stati messi a frutto aumentando il numero di operazioni eseguite in un secondo, ciò che corrisponde proprio alla frequenza dell’orologio interno del chip. Se partiamo dal primo PC Ibm (1981), quando arriviamo al Pentium 4 del 2004, la velocità di esecuzione delle istruzioni è aumentata di 800 volte. Ma, dal 2004 ad oggi, la velocità è cresciuta solamente del 40%. Cos’è successo?

Al crescere della velocità, la quantità di calore generata all’interno del microprocessore ha raggiunto un limite che non si riesce più a compensare con la crescente miniaturizzazione e che non si riesce a smaltire tramite sistemi di raffreddamento compatibili con il design dei prodotti. Per questo, dopo il 2004, Intel ha cominciato a unire più processori dentro un solo chip, prima 2 e, oggi, fino a 10 per i prodotti consumer, molti di più per i server e le workstation professionali. Si segue così una nuova strada: la potenza di calcolo viene espansa, con la possibilità di eseguire più operazioni in parallelo, senza più aumentare in modo significativo la velocità delle operazioni eseguite da ogni singolo processore.

Sul piano della manifattura, la crescita delle prestazioni è stata ottenuta attraverso la miniaturizzazione dei singoli transistor che lo compongono, riducendone così il consumo di energia e la generazione di calore. Dal primo PC Ibm ad oggi, la dimensione di ogni transistor si è ridotta di circa 400 volte. Se, nel 1981, si parlava di 3 micron (10-6 m), oggi utilizziamo processi di produzione a 14 nanometri (1 nm = 10-9m), oppure a 7 nanometri, con riferimento alla dimensione del singolo transistor creato sul wafer di silicio. Più il valore è piccolo, più il processore è potente, efficiente nel consumo di energia e sviluppa meno calore.

Sul piano della manifattura, la crescita delle prestazioni è stata ottenuta attraverso la miniaturizzazione dei singoli transistor che lo compongono, riducendone così il consumo di energia e la generazione di calore. Dal primo PC Ibm ad oggi, la dimensione di ogni transistor si è ridotta di circa 400 volte. Se, nel 1981, si parlava di 3 micron (10-6 m), oggi utilizziamo processi di produzione a 14 nanometri (1 nm = 10-9m), oppure a 7 nanometri, con riferimento alla dimensione del singolo transistor creato sul wafer di silicio. Più il valore è piccolo, più il processore è potente, efficiente nel consumo di energia e sviluppa meno calore.

Oggi la possibilità di condensare sempre più transistor in un microprocessore, sta incontrando un grande ostacolo; è la legge dei rendimenti decrescenti. Col ridursi delle dimensioni del singolo componente, i costi degli impianti aumentano vertiginosamente, insieme al numero di prodotti difettosi che devono essere scartati. Un nuovo processo di fabbricazione di microprocessori prevede un investimento che supera i 10 miliardi di dollari. Il livello estremamente elevato degli investimenti ha fatto sì che, al mondo, siano rimasti solo 4 produttori di microprocessori di alto livello: uno negli Stati Uniti, tre in estremo oriente e nessuno in Europa.

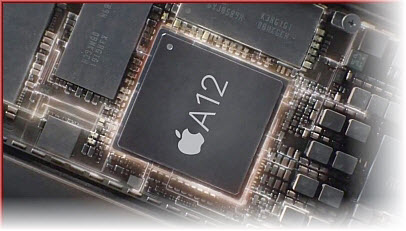

Dal punto di vista della miniaturizzazione, se Intel sembra in affanno, avendo impiegato 6 anni per introdurre un nuovo processo di produzione a 10 nanometri, Apple, a partire da questo autunno, utilizzerà il processo a 5 nanometri della taiwanese TSMC, sia sui dispositivi mobili che sui suoi nuovi Pc. Ciò permetterà di estremizzare il tradizionale design ultrasottile, senza incorrere in problemi di surriscaldamento, e di garantire una durata della batteria molto più lunga nei computer portatili.

nuove strade

Ma la ricerca di migliori prestazioni cerca anche nuove direzioni da percorrere, attraverso un approccio che non sarà più solo quello esclusivo delle miniaturizzazione. Sarà necessario migliorare il funzionamento di tutto il sistema computer.

- Una prima strada sta nella capacità del software di utilizzare in modo più efficiente le macchine. Decenni di crescita continua delle prestazioni hanno visto i programmatori un po’ distratti su questo fronte: la velocità e l’efficienza sarebbero comunque arrivate con la prossima generazione di chip.

Per esempio, non tutte le applicazioni sfruttano nel modo migliore la presenza di più processori in un singolo chip e non tutti i linguaggi di programmazione hanno la stessa efficienza nello sfruttare le risorse dell’hardware.

L’integrazione tra software e hardware è stata sempre un fattore di successo fondamentale nel mondo Apple. Finora si trattava di selezionare e integrare componenti costruiti da terzi, in modo combinato con lo sviluppo del sistema operativo e delle applicazioni. Ora Apple potrà controllare l’intero hardware del computer e ciò dovrebbe spingere molto più in alto l’asticella.

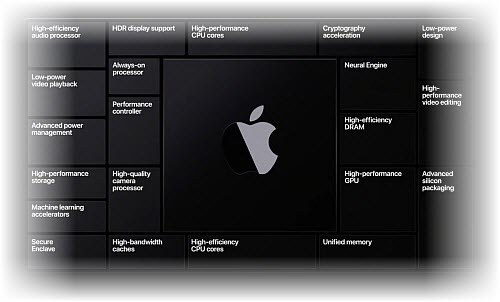

- Un’altra strada per migliorare le prestazioni è offerta dall’utilizzo di chip specializzati e più efficienti nell’eseguire un solo tipo di operazioni: per esempio i calcoli necessari per l’intelligenza artificiale, per la grafica e il video, per la crittografia e la sicurezza dei dati.

I processori degli iPhone, per esempio, includono queste unità dedicate,  integrandole con due processori ad alte prestazioni e 4 ad alta efficienza energetica. Riunire tutte queste unità in un solo chip (system on a chip o SoC) ha il vantaggio di ridurre gli ingombri, la generazione di calore e i tempi morti (latenza) nel trasferimento delle informazioni da una sezione all’altra dell’hardware. Questa tecnologia ha trovato da tempo applicazione negli smartphone e, ora, Apple intende applicarla in modo sistematico anche nei Pc.

integrandole con due processori ad alte prestazioni e 4 ad alta efficienza energetica. Riunire tutte queste unità in un solo chip (system on a chip o SoC) ha il vantaggio di ridurre gli ingombri, la generazione di calore e i tempi morti (latenza) nel trasferimento delle informazioni da una sezione all’altra dell’hardware. Questa tecnologia ha trovato da tempo applicazione negli smartphone e, ora, Apple intende applicarla in modo sistematico anche nei Pc.

Queste le ragioni che, probabilmente, hanno mosso Apple nella sua scelta. Ma perché questa decisione riguarda anche chi non è un cliente dei prodotti di Cupertino?

Come abbiamo visto, siamo in presenza di un impatto enorme dello sviluppo delle tecnologie informatiche sulla società e sull’economia. Ed è oggi di vitale importanza economica sostenerne la crescita, esplorando nuove strade e sviluppando la ricerca di base. Apple accetta la sfida e, con la sua responsabilità di leader tecnologico, indica una strada a tutta l’industria. Come ai tempi del mouse e dell’iPhone, gli altri in-seguiranno.